RTX AI PC:为 AnythingLLM 加速本地 AI 工作流的利器

大语言模型(LLM)基于包含数十亿个 Token 的数据集训练而来,能够生成高质量的内容。它们是众多最热门 AI 应用的核心支撑技术,包括聊天机器人、智能助手、代码生成工具等。

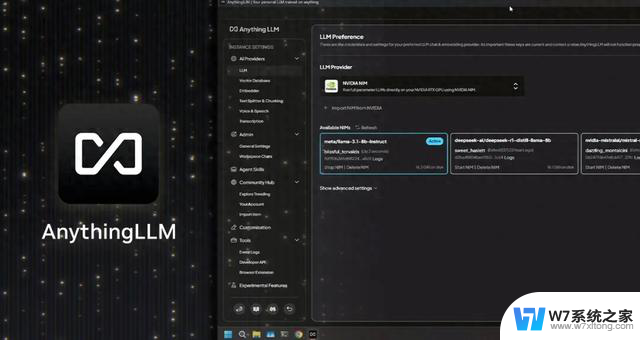

当前,使用 LLM 的便捷方式之一是通过 AnythingLLM。这是一款专为 AI 爱好者打造的桌面应用,能够直接在用户的 PC 上为其提供集众多功能于一体且注重隐私保护的 AI 助手。

随着 NVIDIA GeForce RTX 和 NVIDIA RTX PRO GPU 新增对 NVIDIA NIM 微服务的支持,AnythingLLM 用户可享受更快的性能体验,从而以更快的响应速度运行本地 AI 工作流。

AnythingLLM 是什么?

AnythingLLM 是一款集众多功能于一身的 AI 应用,可供用户运行本地 LLM、检索增强生成(RAG)系统和代理式工具。

它在用户选定的大语言模型与其数据之间起到桥梁作用,可以使用各类工具(即“技能”)。从而能够更轻松高效地将大语言模型应用于特定任务,例如:

AnythingLLM 能够连接各类开源本地大语言模型,也可以连接规模更大的云端大语言模型,包括 OpenAI、微软与 Anthropic 旗下的模型。此外,该应用还通过其社区中心提供了各种技能(skills),用以扩展代理式 AI 的功能。

AnythingLLM 支持一键安装,且可作为独立应用或浏览器扩展程序发布,无需复杂设置即可提供直观易用的体验,是 AI 爱好者(特别是 GeForce RTX 和 NVIDIA RTX PRO GPU 用户)的绝佳选择。

RTX 为 AnythingLLM 提供加速

GeForce RTX 与 NVIDIA RTX PRO GPU 能够大幅提升 AnythingLLM 中 LLM 与智能体的运行性能,通过专为加速 AI 而设计的 Tensor Core 加速推理。

AnythingLLM 通过 Ollama 运行 LLM,并通过 Llama.cpp 及 GGML 机器学习张量库加速端侧执行。

Ollama、Llama.cpp 和 GGML 针对 NVIDIA RTX GPU 和第五代 Tensor Core 进行了优化。

随着 NVIDIA 不断推出新的 NIM 微服务和参考工作流(例如其日益壮大的 AI Blueprint 库),像 AnythingLLM 这样的工具将解锁更丰富的多模态 AI 用例。

AnythingLLM — 现已支持 NVIDIA NIM

AnythingLLM 最近新增 NVIDIA NIM 微服务(性能经过优化的预打包生成式 AI 模型)支持,助力用户在 RTX AI PC 上通过精简易用的 API 轻松启动 AI 工作流。

对于希望在工作流中对生成式 AI 模型进行快速测试的开发者而言,NVIDIA NIM 非常实用。用户无需自行寻找最适用的模型、下载全部文件并为所有组件设置连接,因为 NVIDIA NIM 微服务提供了包含一切必需组件的单一容器。此外,它们在云端与 PC 端均可运行,因而便于开发者在本地完成原型设计,然后再部署到云端。

这些微服务均可以通过 AnythingLLM 用户友好型界面使用,让用户可以快速测试与实验。随后,用户可以利用 AnythingLLM 将其连接至工作流,也可以通过 NVIDIA AI Blueprint、NIM 文档及示例代码将其直接集成到相关应用或项目中。

RTX AI PC:为 AnythingLLM 加速本地 AI 工作流的利器相关教程

-

英伟达欧洲布局20个AI超级工厂 两年内算力提升10倍,加速AI技术发展

英伟达欧洲布局20个AI超级工厂 两年内算力提升10倍,加速AI技术发展2025-06-17

-

AMD Radeon RX 9060 XT:2048个流处理器,加速频率高达3.2GHz

AMD Radeon RX 9060 XT:2048个流处理器,加速频率高达3.2GHz2025-04-15

-

-

每个人的 AI 伙伴:让人工智能成为你的生活助手

每个人的 AI 伙伴:让人工智能成为你的生活助手2024-10-08

- 外媒:AMD 全球裁员 4% 以加速 AI 芯片研发,公司未来发展重心转向人工智能技术

- AI技术,正在通过光加速传递?未来传输速度将大幅提升

- AMD新GPU性能超英伟达H200,数据中心AI加速器市场规模预计达5000亿美元

- 英伟达解决Blackwell GPU问题,摩根士丹利预计量产将快速提速

- 消息称AMD 6月推专为AI设计的双槽版Radeon PRO W7900显卡发布,性能强劲,助力人工智能创新

- 对抗英伟达,AMD的另一把利器:如何选择适合你的显卡?

- AMD CPU销量震撼,英特尔还有翻盘机会吗?

- 索泰(ZOTAC)GEFORCE RTX 5070Ti 16GB天启OC显卡测试:性能如何?

- 微软确认Win11 25H2将于9至10月推送,与24H2共用平台,Win11最新版本推送时间确定

- 微软称 Windows 11 版 Outlook 功能更强大 是时候拥抱它了,提升工作效率必备!

- 摩根士丹利:微软对OpenAI的投资正在取得成功,AI领域迎来新突破!

- 我国自主研发新一代CPU发布,无需依赖国外技术

热门推荐

微软资讯推荐

- 1 AMD CPU销量震撼,英特尔还有翻盘机会吗?

- 2 索泰(ZOTAC)GEFORCE RTX 5070Ti 16GB天启OC显卡测试:性能如何?

- 3 微软确认Win11 25H2将于9至10月推送,与24H2共用平台,Win11最新版本推送时间确定

- 4 RTX AI PC:为 AnythingLLM 加速本地 AI 工作流的利器

- 5 自主研发新一代CPU,来了!最新技术发布

- 6 英伟达市值3.77万亿美元排第一,股价创历史新高,成为全球市值最高的公司

- 7 四款高性价比甜品级别游戏显卡推荐,新手小白必看

- 8 Windows 11新“开始”菜单禁止创建新类别,部分应用被归类为“其他”

- 9 全新 NVIDIA AI Blueprint 推动电信网络配置自动化GTC 巴黎

- 10 对抗英伟达,AMD的另一把利器:如何选择适合你的显卡?

win10系统推荐

系统教程推荐